С чего начиналось SEO

Многое можно сказать (и уже было сказано!) о поисковой оптимизации, поэтому вместо того, чтобы представить очередной анализ последних данных, на этот раз мы обратимся к прошлому, чтобы больше понять об истории SEO и будущем этой технологии.

Ключевые моменты в SEO историиЗачем вообще заморачиваться с историей? Что ж, при работе с поисковыми системами с самого начала почти не поменялись следующие факторы:

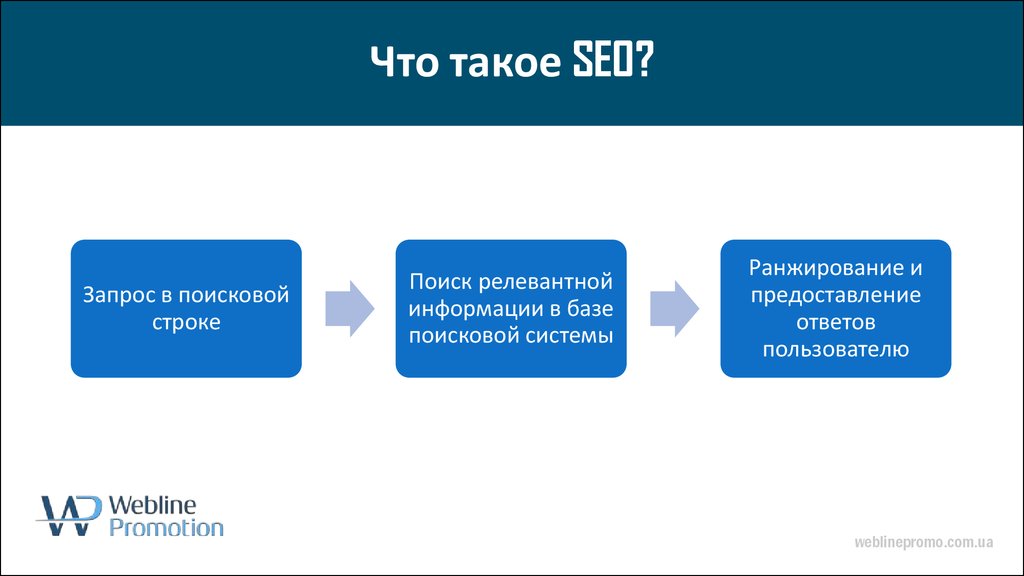

- Работа поисковых систем;

- Какие ключевые слова и фразы они используют;

- Какие поисковые системы они предпочитают.

Однако внутри этих факторов многое изменилось. За этим кроется две основные причины:

- Поисковые системы хотят, чтобы результаты были максимально релевантными, потому что качество результатов поиска — это то, что заставляет пользователей возвращаться.

- В непрерывной борьбе за власть поисковики постоянно развиваются, чтобы предоставлять максимально точные результаты.

В то же время бренды пытаются найти и внедрить методы оптимизации, чтобы получить долю органического поискового трафика у конкурентов.

В то же время бренды пытаются найти и внедрить методы оптимизации, чтобы получить долю органического поискового трафика у конкурентов.

Ниже кратко изложим историю поисковых систем и расскажем, как SEOразвивались за последние 20 лет.

Начало SEO-продвижения (в далеком 1994 году)Если вы хотели найти что-то в Интернете, вы шли на «Апорт», Rambler или Yahoo. Однако автоматическое индексирование новых сайтов и SEO в том виде, в каком мы его знаем еще не было. Потребовалось дождаться 1995 года, чтобы эта технологиях начала развиваться.

Один из первейших поисковиков YahooПервые дни SEO (1995 — 1997)Это было время, когда впервые появилось много новых поисковых систем. Среди них Lycos и AltaVista (которая позже стала известна, как Evreka в Швеции).

Это стало началом автоматического индексирования или «сканирования» сайтов и предвещало подъем в истории становления SEO. Внезапно слова стали крайне важными в результатах поиска и того, как и какие страницы сайта отображаются в алгоритме поисковой системы.

Внезапно слова стали крайне важными в результатах поиска и того, как и какие страницы сайта отображаются в алгоритме поисковой системы.

Владельцы веб-сайтов использовали это, чтобы экспериментировать с простыми методами воздействия на результаты поиска, например, заполняя страницу словами и предложениями, которые были невидимы невооруженным глазом, но могли быть найдены поисковыми системами. Классический пример — белый текст на белом фоне.

Проблема заключалась в том, что они не делали веб-сайты более релевантными для посетителей, а только снижали качество результатов поиска.

Затем появился Google (1998 — 1999)Поисковик был запущен в ответ на потребность в более актуальных результатах выдачи. Google разработал то, что они назвали алгоритмом «PageRank» (один из алгоритмов ссылочного ранжирования), который основывался на количестве ссылок на странице и на том, насколько они были влиятельными. Идея заключалась в том, что если на сайте много ссылок, то он, вероятно, популярен, а значит более качественен, чем сайты с меньшим количеством ссылок.

В результате буквально за одну ночь Google занял доминирующее место для поиска, изменив приоритет SEO от «черной» тактики скрытого и нерелевантного контента прошлого.

Рост ссылок (2000 — 2001)В начале 2000-х годов Google запустил инструмент для браузеров под названием «Панель инструментов Google», который также показывал PageRank отдельных страниц. Это привело к тому, что сайты обменивались ссылками друг с другом и другими сайтами с высоким рейтингом. В конце концов дошло до того, что появились торговые площадки для обмена ссылками, и качество результатов поиска снова начало испаряться.

Ключевые слова (2002 — 2003)Чтобы пресечь покупку ссылок, Google решил наказать все веб-сайты, которые принимали участие в этой практике. После этого в центре внимания снова оказались другие теневые методы — например, заполнение страниц ключевыми словами, повторяющимися снова и снова. Как и в случае с невидимым текстом, это не привело к тому, что страницы стали более релевантными для пользователей, наоборот, это только обманывало поисковики.

В результате появилось обновление «Флорида», которое наказывало сайты за использование этой тактики и затронуло такую большую часть результатов поиска, что поставило на уши всю сложившуюся SEO-индустрию.

Интересный фактДорвеи (2004 — 2005)После внесения значительных изменений необходимо было изобрести что-то новое (конечно!), чтобы сайты могли конкурировать в выдаче и выходить в топ позиций. Следовательно, в 2004 году техника под названием «Дорвеи» заняла центральное место.

Эти страницы часто были плохо спроектированы с точки зрения посетителя, и их единственная цель заключалась в том, чтобы получить высокий рейтинг по определенным поисковым запросам. Посетители приземлялись на дорвее, а оттуда направлялись к «настоящему» месту назначения.

Разумеется, этот новый способ оптимизации трафика из поисковых систем тоже просуществовал недолго, и игра в кошки-мышки продолжилась.

Краткая маскировка (2000 — 2007)В 2006 году BMW пора было забанить и полностью удалить из результатов поиска Google за использование метода, называемого маскировкой, что означает показ одного типа контента для поисковых систем и другого для пользователей.

К 2008 году стало очевидно, что социальные сети становятся важной онлайн-активностью. Facebook (данная соцсеть запрещена в РФ и принадлежат компании Meta, которая признана в РФ экстремистской) превзошел по популярности некогда могущественный Myspace, насчитывая около 140 миллионов активных пользователей, а Apple, выпустившая iPhone годом ранее, была на пути к тому, чтобы навсегда изменить онлайн-ландшафт.

Интерес к социальным сетям должен был отражаться в результатах поиска. Таким образом, и Bing (запущенный в 2009 году), и Google включали записи социальных сетей в результаты выдачи. Google вносит от 350 до 550 корректировок в свой алгоритм поиска в год.

В 2010 году Google подтвердил, что в 2009 году он вносил от 350 до 550 корректировок в свой поисковый алгоритм, то есть не реже одного раза в день, что свидетельствует о быстром продвижении, необходимом для того, чтобы оставаться на вершине SEO.

Качественный контент, он же Панда и Пингвин (2011 — 2012)К 2010 году появилась тактика, когда сайты создавались из большого количества некачественного текстового контента, часто обновляемого и специально разработанного для привлечения алгоритмов поисковых систем. Эти сайты были связаны друг с другом, образуя так называемые «контент-фермы», единственной целью которых было привлекать трафик и, как и дорвеи до них, направлять входящий трафик в конечный пункт назначения.

Эти сайты были связаны друг с другом, образуя так называемые «контент-фермы», единственной целью которых было привлекать трафик и, как и дорвеи до них, направлять входящий трафик в конечный пункт назначения.

В ответ Google решил, что качество контента должно иметь большее значение для рейтинга в поисковиках, и в 2011 году запустил обновление «Панда», которое фактически искоренило эту практику. Позже за этим последовал «Пингвин», который сосредоточился на сайтах, содержащих нерелевантные ссылки, незаметно добавленные к контенту, релевантному для посетителя.

Фильтры GoogleСкрытие данных ключевых слов и приоритет мобильных устройств (2013 — 2017)Вслед за Panda и Penguin Google также начал шифровать поисковые запросы, используемые отдельными пользователями, чтобы сайты не могли получить доступ к данным. Сначала это было только для пользователей, которые выполняли поиск, войдя в Google, но в 2013 году это было развернуто для всех пользователей.

Затем акцент сместился в сторону мобильных устройств. Сначала в 2014 году, когда была запущена индексация приложений, в результате чего они отображались рядом с сайтами в результатах поиска, а затем в 2015 году с так называемым обновлением «Mobilegeddon», которое делало адаптивность — сигналом к ранжированию в поисковике.

Сначала в 2014 году, когда была запущена индексация приложений, в результате чего они отображались рядом с сайтами в результатах поиска, а затем в 2015 году с так называемым обновлением «Mobilegeddon», которое делало адаптивность — сигналом к ранжированию в поисковике.

В 2016 году было выпущено еще одно мобильное обновление, направленное на борьбу с раздражающими посетителей сайтами, показывая баннеры и всплывающие окна вместо контента, который они искали. Более того, в ноябре Google объявил о переходе на «мобильную индексацию», т. е. предпочтение мобильной версии страницы над настольной версией. (Если ваш сайт адаптивный, то не беспокойтесь).

Сейчас и позже (2018 — )2018 год начался с того, что мобильные устройства стали ключевым направлением деятельности поисковых систем. Google объявил, что с июля 2018 года скорость страницы будет фактором ранжирования для мобильного поиска.

Помимо мобильных устройств, еще одна явная тенденция заключается в том, что мы используем более длинные и более подробные поисковые запросы, такие как фразы «рядом со мной», «для меня» или «должен ли я». Поисковые системы усердно работают над пониманием таких намерений пользователей. Сегодня 50% поисковых запросов состоят из четырех слов или длиннее, и это число будет только увеличиваться. По мере того, как мы переходим к голосовому поиску на мобильных и домашних колонках с помощью наших цифровых персональных помощников, голосовой поиск все чаще становится повседневной речью.

Поисковые системы усердно работают над пониманием таких намерений пользователей. Сегодня 50% поисковых запросов состоят из четырех слов или длиннее, и это число будет только увеличиваться. По мере того, как мы переходим к голосовому поиску на мобильных и домашних колонках с помощью наших цифровых персональных помощников, голосовой поиск все чаще становится повседневной речью.

Прогнозируется что благодаря увеличению вычислительной мощности и развитию искусственного интеллекта к 2024 году 50% всех поисковых запросов будет осуществляться голосом. В конечном итоге более широкое использование искусственного интеллекта окажет значительное влияние не только на поисковые системы, но и на маркетинг в целом.

В мире растет доля мобильного трафикаЧто мы можем узнать о будущем SEO, глядя в прошлое?Поскольку поисковые системы постоянно развиваются по мере того, как мы, люди, меняем свое поведение и адаптируемся к новым технологиям, SEO-оптимизация должна развиваться в ногу со временем (то, что хорошо работало вчера, не обязательно будет работать завтра).

В краткосрочной перспективе можно было «обмануть» поисковую систему, заставив ее поверить, что ваш сайт отвечает данному запросу и, чем он есть на самом деле, но в долгосрочной перспективе такая тактика никогда не была и не будет выигрышной.

Успешные поисковые системы всегда ориентируются на удобство работы пользователей и качество результатов поиска. Это приносит пользу веб-сайтам, которые сосредоточены на предоставлении контента, который приносит пользу их целевой аудитории.

История развития SEO

Зачем изучать историю SEO?Знание истории помогает не повторять одни и те же ошибки. Кроме того, оно позволяет понять, какие технологии всё ещё являются актуальными, а какие уже остались в прошлом. Многие из устаревших методик не только не принесут пользу, но и могут навредить.

Интернет изначальный: до поисковиков и SEO1991 год — это дата создания первого веб-сайта в интернете. Тогда Сеть объединяла в одну множество подсетей различных учебных заведений во всём мире. Изначально количество веб-ресурсов было невелико, и их адреса пользователи передавали друг другу. Адрес просто вводили в адресную строку и попадали непосредственно туда, куда было надо.

Изначально количество веб-ресурсов было невелико, и их адреса пользователи передавали друг другу. Адрес просто вводили в адресную строку и попадали непосредственно туда, куда было надо.

Однако постепенно сеть росла, добавлялись всё новые и новые ресурсы. Это были уже не только утилитарные, полезные в работе и учёбе площадки, но и развлекательные: игры, библиотеки, музыка, хостинги картинок и так далее.

Ориентироваться в этом многообразии с каждым годом становилось всё сложнее. В это время появляются посредники между веб-мастерами и посетителями: каталоги, где можно было найти самые популярные площадки по заданной теме.

Но быстро стало понятно, что они со своей задачей не справляются. Их вручную наполняли люди, и делалось это намного медленнее, чем появлялись новые веб-ресурсы. Поэтому им довольно быстро нашлась замена. С другой стороны, некоторые тематические каталоги существуют и сегодня. Особой популярностью они не пользуются, но и полностью не закрываются.

На смену каталогам пришли поисковикиПервый поисковый сайт начал работу в 1994 году, это был WebCrawler. Вслед за ним появились и другие. В 1995 году начали работать: AltaVista, Yahoo и Lycos. В 1997 году Ларри Пейдж и Сергей Брин запустили собственный сервис, который сегодня известен под названием Google. Самый известный российский поисковик — Yandex — начал работать в том же году.

Вслед за ним появились и другие. В 1995 году начали работать: AltaVista, Yahoo и Lycos. В 1997 году Ларри Пейдж и Сергей Брин запустили собственный сервис, который сегодня известен под названием Google. Самый известный российский поисковик — Yandex — начал работать в том же году.

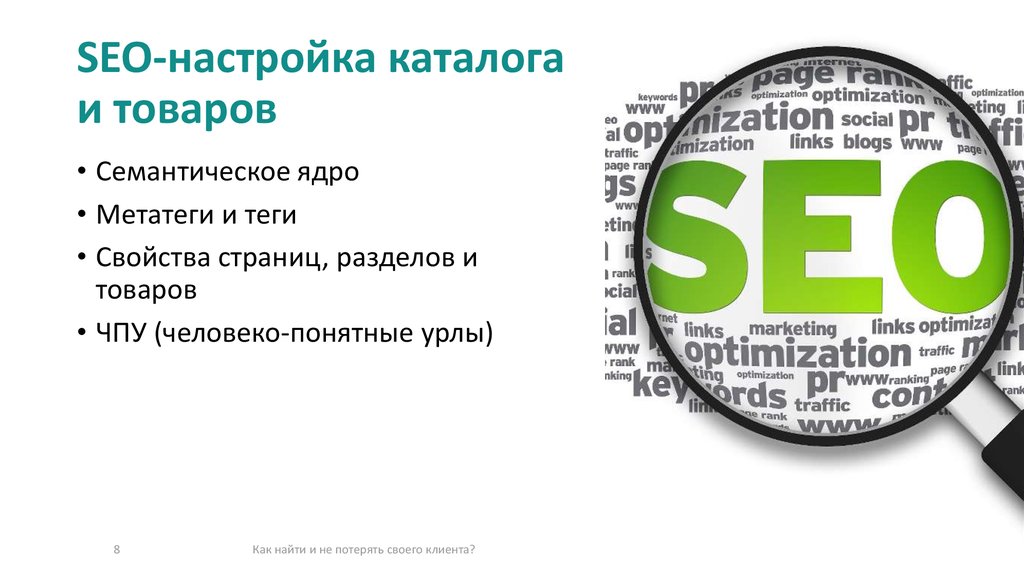

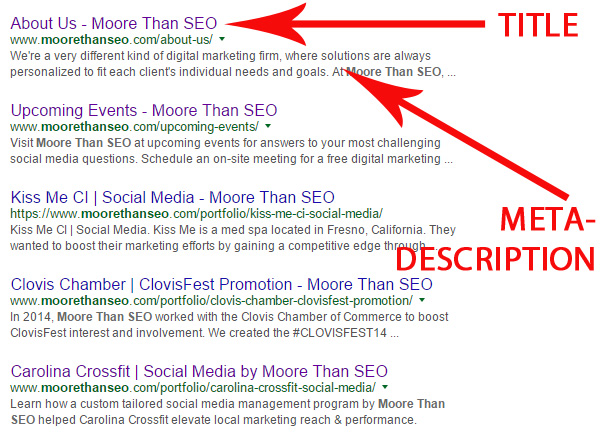

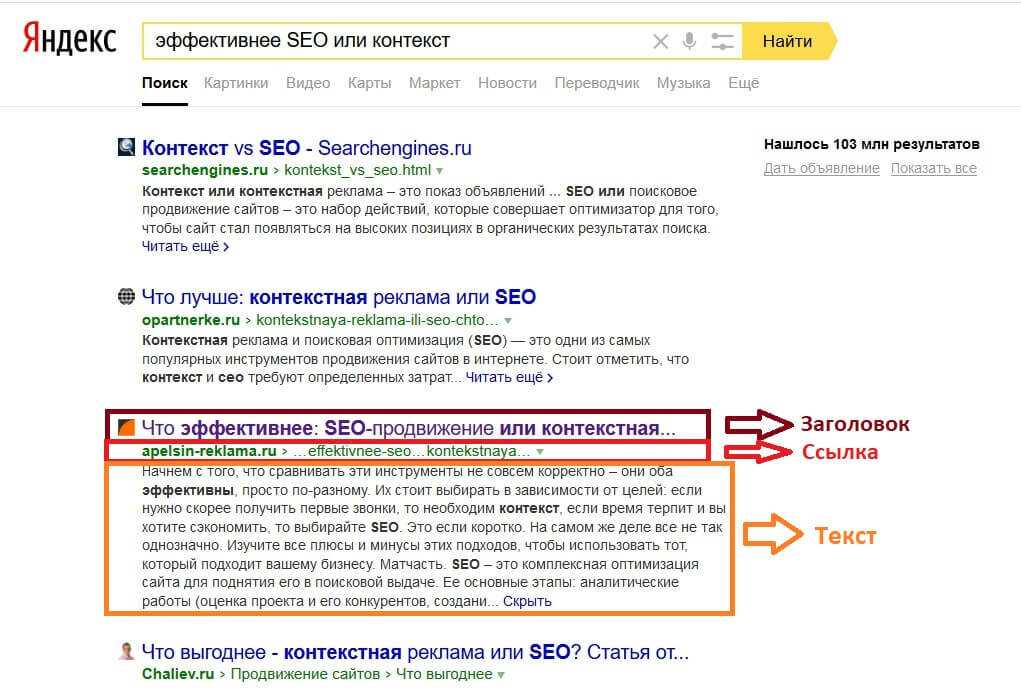

- Title — название

- Description — описание

- Ключевые слова

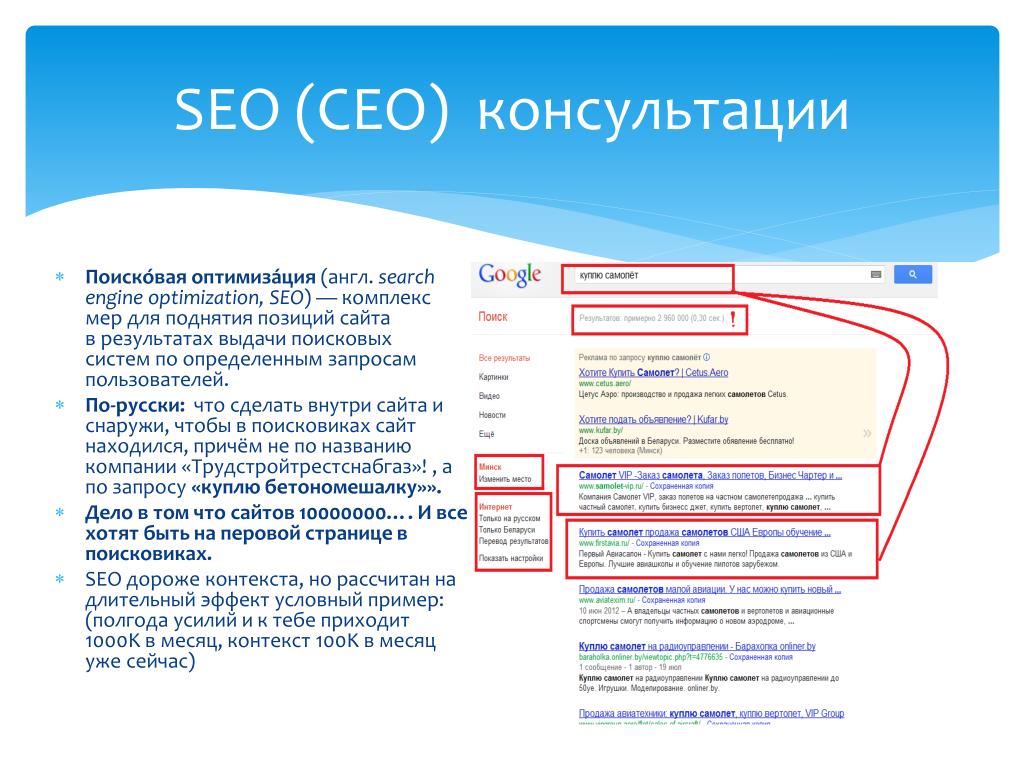

Естественно, изначально они не умели грамотно анализировать контент. Поэтому опирались на описания, которые давали владельцы в метатегах

Они отслеживали, как часто ключевые слова встречаются в тексте, чтобы убедиться, что тема соответствует заявленной.

Вообще, попытки влиять на выдачу с помощью различных ухищрений и методик начались с момента появления поисковиков, и потому их истории и деятельность неотделимы друг от друга.

Однако SEO-технологии — целая система, в которой для каждого метода отведено своё место. И в этом смысле основоположником SEO считается Дэнни Салливан. Он настолько заинтересовался продвижением через поисковики, что потратил время на полномасштабные исследования и выпустил книгу, описывающую актуальные на тот момент методики.

Он настолько заинтересовался продвижением через поисковики, что потратил время на полномасштабные исследования и выпустил книгу, описывающую актуальные на тот момент методики.

Практически с первых лет SEO-продвижение разделилось на белое и чёрное. Началось противостояние сеошников и владельцев поисковых систем.

К чёрному SEO относили самые простые способы продвижения, которые при этом делали страницу бесполезной для пользователей:

• переспам: перенасыщение большим количеством ключей. Текст становился нечитаемым, зато сайт выходил на верхние места в выдаче;

• дорвей: ресурс, главная цель которого — перенаправить посетителя на другую площадку. Зачастую сам дорвей невозможно даже рассмотреть;

• клоакинг: в этом случае информация на странице и та, которую сайт выдаёт поисковику, кардинально различается.

Естественно, такие методы мешали людям находить интересные и полезные веб-ресурсы, из-за чего падала популярность поисковиков. Такая ситуация их не устраивала, и они всячески старались бороться с чёрным SEO.

Такая ситуация их не устраивала, и они всячески старались бороться с чёрным SEO.

Алгоритмы постоянно совершенствовались, чтобы улучшить выдачу. Со временем они начали учитывать не только метатеги и количество ключей, но и внешний вид страницы, структуру текста и так далее. В итоге веб-сайты, продвигаемые с помощью чёрных методик, в выдаче показывались на более низких позициях.

Новые фильтры и дополнения к существующим алгоритмам ранжирования до сих пор выходят с завидной регулярностью, порой по несколько раз в месяц.

Впрочем, раньше обновлений было ничуть не меньше. Правда, большинство из них радикальных изменений не вызывали. Но некоторые в корне меняли представление о поиске и оптимизации.

Персонализация поискаВ начале 2000-х поисковики начали учитывать при формировании выдачи не только текущий запрос, но и предыдущую историю запросов. Это позволяет сделать поиск более персонализированным. Люди получают именно те результаты, которые им будут наиболее интересны.

Люди получают именно те результаты, которые им будут наиболее интересны.

Сегодня эта технология шагнула далеко вперёд, и её можно использовать в процессе оптимизации сайта, выстраивая его под определённую целевую аудиторию.

Однако с этим связаны и определённые проблемы. Прежде всего, правового характера, ведь сбор и использование подобной информации противоречит законам многих стран. И данное противоречие до сих пор не разрешено до конца.

Page RankВ 2005 году Google предложил новый алгоритм ранжирования, который назывался Page Rank. Он высчитывал вес страницы, ориентируясь на значимость и количество ссылок на неё с посторонних площадок. Логика была такая: раз на интернет-ресурс ссылаются другие веб-сайты, значит, он действительно полезен и удобен. Следом и Yandex выпустил свой ТИЦ — индекс цитирования.

С этого момента начинается ссылочный период в развитии SEO-технологий. Происходит разделение на внутреннюю и внешнюю оптимизацию. К внешней относился процесс наращивания ссылочной массы. Получить ссылки можно было несколькими способами:

Получить ссылки можно было несколькими способами:

• зарегистрироваться в тематическом каталоге;

• обменяться ссылками с другими веб-ресурсами;

• закупить ссылки на специальных биржах.

С каждым годом таких бирж становилось всё больше. Они позволяли быстро увеличить вес страницы, при этом не задумываясь над тем, какие интернет-площадки переправляют пользователей на веб-страницу.

Естественно, качество ссылок в этом случае оставляло желать лучшего, так что и этот приём относится к чёрному SEO.

Алгоритм машинного обучения2005-2009 годы считаются периодом кризиса поисковых сайтов. Причиной тому была их несостоятельность. Существующие методы не позволяли настроить выдачу так, чтобы первые строчки занимали полезные для людей площадки, а не те, чья популярность искусственно накручена.

Ситуацию переломило введение машинного обучения. Теперь алгоритмы ранжирования сами стали строить формулы сравнения различных интернет-ресурсов на основании тех данных, что изначально заложили создатели, и тех, что они получают в процессе работы.

Первым и лучшим в этот раз оказался сервис Yandex с его методом машинного обучения Матрикснет, появившимся как раз в 2009 году.

В этот период заговорили о том, что SEO перестанет быть эффективным, что его время уходит. Однако в итоге получилось совсем иначе: неактуальными стали только технологии из чёрного SEO, которые мешали пользователям найти нужную информацию.

А легальное SEO стало по-настоящему интересным процессом, требующим творческого подхода и многих знаний по этой теме.

МинусинскЭтот алгоритм от Yandex отслеживает некачественные ссылки

и переоптимизированные

по этому показателю интернет-ресурсы и выключает из выдачи на срок до нескольких месяцев.

Причем под санкции попадают именно порталы, на которых объём купленных ссылок выше естественных намного больше,

чем в два раза.

Работать он начал весной 2015 года. С этого времени и внешняя оптимизация стала требовать знаний и усилий. Ниже перечислены условия, позволяющие избежать санкций от «Минусинска»:

- Оптимальный баланс купленных ссылок

- Постепенное наращивание ссылочной массы

- Качественные сайты-доноры

- Упор на естественные ссылки

Естественно, это сильно изменило выдачу. Теперь на первые страницы стало проще пробиться тем, кто использует легальные методы оптимизации.

Теперь на первые страницы стало проще пробиться тем, кто использует легальные методы оптимизации.

Многие алгоритмы и фильтры от Yandex носят названия различных городов. Этот фильтр назван в честь популярного курорта в Германии. Его запустили в марте 2017 года, и уже в следующие 2 недели веб-мастеров начало лихорадить, поскольку многие веб-ресурсы существенно потеряли в трафике из-за штрафных санкций.

Новый текстовый фильтр был направлен на отслеживание и понижение в выдаче переоптимизированных страниц. Он был призван вывести на первые места удобные, полезные и интересные для людей ресурсы, а не тексты, рассчитанные на взаимодействие с машинами.

С этого времени снова начались разговоры о смерти SEO-оптимизации. Однако и сегодня без грамотной работы в этом направлении выбиться в ТОП невозможно.

SEO-технологии сегодняВсе эти изменения и дополнения привели к тому, что SEO стало не просто технологией, а настоящим искусством. Основной тренд — создание сайта, ориентированного одновременно на людей, и на поисковые алгоритмы. Причём упор делается на человека, а программа в данном случае вторична.

Основной тренд — создание сайта, ориентированного одновременно на людей, и на поисковые алгоритмы. Причём упор делается на человека, а программа в данном случае вторична.

Каждый поисковик стремится создать памятку для веб-мастеров, в которой расписаны легальные методы поискового продвижения веб-сайтов.

Связаться с менеджером

С нами работаютРекламные и маркетинговые агентства

Организации, которые привлекают интерес потребителей к клиентским товарам и услугам с помощью средств массовой информации, часто нестандартными и креативными методами.

Интернет-магазиныСпециальные сайты для онлайн-торговли всевозможными товарами и услугами, дающие возможность пользователю удовлетворить свои нужды, не выходя из дома.

Корпоративные сайтыОнлайн-представительства различных компаний и структур — от строительства до ресторанов, от нефтяных гигантов до банков и парикмахерских.

продвижения

Бюро и коллективы, раскручивающие и оптимизирующие любые сайты безопасным и эффективным способом, помогая заказчикам стать ближе к потенциальным клиентам.

МаркетплейсыЭлектронные магазины-посредники, своего рода интернет-супермаркеты, которые помогают покупателям и продавцам взаимодействовать с минимальными временными затратами.

Информационные сайты, блоги

Библиотеки полезной и важной информации, а также публичные дневники известных лиц, которые дают широкий спектр сведений для работы, учёбы и отдыха современных людей.

Заказать SEO продвижение

Viber-blackCreated with Sketch.image/svg+xmlМы помогаем перейти на качественно новый уровень развития проекта,

освобождая время на решение новых задач

Захватывающая история SEO: от 90-х до наших дней

Контент-маркетологи соревнуются в создании контента, оптимизированного для SEO, но как вообще появилась поисковая оптимизация? Читайте дальше, чтобы узнать все об истории SEO, о том, как оно развивалось и куда движется.

Когда началось SEO?

Концепция SEO зародилась еще до создания Google. Согласно легенде, группа Jefferson Starship послужила одной из основных причин термина SEO около 19 лет.95-1997. Промоутер Боб Хейман получил гневный звонок от группы, когда они были в дороге и не смогли найти свою веб-страницу.

Несколько фан-сайтов так страстно писали о «Jefferson Starship», что они превзошли настоящую страницу группы в поисковой выдаче. Таким образом, Хейман и его партнер Леланд Харден увеличили количество упоминаний «Звездного корабля Джефферсона» на официальной странице, что вывело их на вершину рейтинга.

Кто изобрел термин SEO?

Согласно этому анекдоту, Боб Хейман и Леланд Харден изобрели термин SEO около 19 лет.95-1997, но эксперты задаются вопросом, насколько эта история правда или вымысел. В то время, чтобы повысить эффективность SEO, вам просто нужно было несколько входящих ссылок, исходящих ссылок, несколько ссылок на ключевую фразу вашего фокуса и работающий веб-сайт. К середине-концу девяностых несколько пионеров технологий начали использовать эту тактику, чтобы увидеть значительные результаты.

К середине-концу девяностых несколько пионеров технологий начали использовать эту тактику, чтобы увидеть значительные результаты.

В 1997 году маркетинговое агентство Webstep стало первой группой, использовавшей фразу «поисковая оптимизация» в своих маркетинговых материалах. А около 19В 98 году Дэнни Салливан, основатель Search Engine Watch, начал популяризировать этот термин и помогать клиентам оптимизировать свой контент, чтобы он занимал высокие позиции в результатах поиска.

К 2003 году термин «поисковая оптимизация» впервые появился в Википедии, укрепив свой статус в интернет-культуре и вдохновив растущую индустрию консультантов и аналитиков, помогающих компаниям подняться на вершину результатов поисковых систем.

Неудачная попытка защитить авторские права на термин «SEO»

Несмотря на то, что индустрия SEO вступала в свои права, многие маркетологи использовали тактику черных шляп или словесное наполнение для повышения эффективности поиска. Но в 2007 году Джейсон Гамберт, который может быть реальным человеком, а может и не быть, попытался присвоить товарный знак термину «SEO». Гамберт якобы хотел защитить целостность поисковой оптимизации и спасти Интернет от компаний, наживающихся на потребителях.

Гамберт якобы хотел защитить целостность поисковой оптимизации и спасти Интернет от компаний, наживающихся на потребителях.

Неудивительно, что другие контент-маркетологи и эксперты по поисковой оптимизации не были в восторге от этой разработки, равно как и Патентное ведомство США, которое к 2008 году отказало в регистрации товарного знака9.0003

SEO и подъем Google

В то время как SEO предшествовало Google , подъем этой безжалостной поисковой системы, начатой Ларри Пейджем и Сергеем Брином, доминировал в SEO почти 20 лет. Таким образом, несмотря на то, что люди ссылаются на общие поисковые системы, Google имеет наибольшее значение в истории SEO . Учитывая, что на долю Google приходится почти 93% использования поисковых систем, это доминирование, вероятно, не исчезнет в ближайшее время.

Но одна из главных причин, по которой Google удалось обойти Yahoo, AltaVista, Dog Pile, Infoseek, Ask Jeeves и многих других, заключается в том, что он обеспечивает лучшие результаты поисковых запросов. Он также вложил значительные средства в обучающие машины для увеличения данных, чтобы продолжать совершенствовать свой процесс. По состоянию на 2021 год он оценивает более 200 факторов при определении рейтинга SEO, но со временем их количество увеличилось.

Он также вложил значительные средства в обучающие машины для увеличения данных, чтобы продолжать совершенствовать свой процесс. По состоянию на 2021 год он оценивает более 200 факторов при определении рейтинга SEO, но со временем их количество увеличилось.

Как развивалось SEO?

Поскольку Google уже несколько лет является доминирующей силой в индустрии SEO, многие ключевые даты связаны с последним обновлением Google Core . Таким образом, рассмотрение истории поисковой оптимизации через призму поиска Google может быть чрезвычайно полезным для понимания того, как изменился традиционный поиск за эти годы и какие критерии имеют наибольшее значение.

Компания Google часто вводила новые алгоритмы в свою систему алгоритмов, предлагая различные функции, улучшающие общее качество результатов поиска. Мэтт Каттс, руководитель отдела веб-спама и поискового инженера Google с 2001 по 2016 год, разработал многие из этих обновлений. Каждое обновление алгоритма приводит либо к агонии, либо к экстазу для контент-маркетологов, а также к перетасовке индексации доменов и определению того, что на самом деле является «релевантным контентом». Но понимание этой краткой истории может оказаться чрезвычайно полезным, когда дело доходит до предсказания новых 9Тенденции отрасли 0009.

Но понимание этой краткой истории может оказаться чрезвычайно полезным, когда дело доходит до предсказания новых 9Тенденции отрасли 0009.

Как изменились алгоритмы Google?

История SEO. содержит множество изменений в алгоритмах Google, и все они работают вместе для достижения цели предоставления более релевантного контента для пользователей . Эти обновления, как правило, выполняют одну из трех задач: отфильтровывают спам и тактику черных шляп, отдают приоритет свежему, актуальному, местному контенту или предоставляют релевантные результаты для семантического поиска.

Понимая эту эволюцию, становится легче увидеть, как обычный поиск становится все более совершенным. Вы также можете увидеть, как разные алгоритмы строятся на прошлых. Однако имейте в виду, что Google продолжает совершенствовать и обновлять каждое из этих обновлений. Таким образом, хотя алгоритму может быть более десяти лет, он все еще влияет на результаты поиска сегодня. Версия 4 алгоритма будет сильно отличаться от версии 1. Вот несколько ключевых алгоритмов, которые сформировали историю SEO.

Версия 4 алгоритма будет сильно отличаться от версии 1. Вот несколько ключевых алгоритмов, которые сформировали историю SEO.

1996 PageRank

Этот ранний проект, созданный Сергеем Брином и Ларри Пейджем, помог проложить путь гиганту, который впоследствии стал Google. Он взвешивал факторы, включая авторитетность домена, а также внутренние и внешние ссылки. Хотя этот алгоритм создал прочную основу для автоматического индексирования Интернета, он по-прежнему был уязвим для тактики Black Hat .

2003 Флорида

Это первое крупное обновление алгоритма Google, предназначенное для фильтрации сайтов с большим количеством некачественных ссылок. Они выпустили его в ноябре, и он произвел огромный переворот на многих сайтах, как раз в разгар сезона рождественских распродаж. К сожалению, многие качественные сайты были помечены неправильно, что нанесло значительный ущерб малому бизнесу. Однако введение анализа ссылок помогло сформировать траекторию SEO.

2004 TrustRank

Алгоритм TrustRank вышел за рамки основания Флориды как способ отфильтровать СПАМ и методы Black Hat из результатов других поисковых систем. Этот алгоритм помогает определить, насколько надежными являются домены, чтобы пользователи получали качественные результаты.

2010 Google Caffeine

Этот алгоритм придал результатам поиска Google приятный заряд энергии, так как возможности индексирования статей увеличились, а результаты поиска смогли отдавать приоритет более свежему контенту.

2011 Google Panda

Google Panda был разработан, чтобы направлять людей на более качественные сайты, такие как новостные организации, и минимизировать влияние ферм контента с плохо написанными, плохо цитируемыми статьями.

2011 Google Freshness

Некоторые веб-сайты, такие как хороший рецепт, могут быть вечными, но подавляющее большинство нуждается в обновлениях довольно часто. Алгоритм Google Freshness делает именно то, что вы ожидаете; в нем приоритет отдавался свежему актуальному контенту, и он был улучшением ранее выпущенного Caffeine.

2012 Google Penguin

Как и Panda, Google Penguin нанес еще один удар по спам-сайтам, пытаясь отсеять контент, используя скрытые методы, чтобы повысить свой рейтинг. Поэтому спамьте веб-сайты, которые будут создавать страницы с большим количеством внешних ссылок, ведущих на них, чтобы повысить авторитет своего домена и позицию в результатах поиска.

2013 Google Hummingbird

Этот надежный алгоритм предложил масштабный переход к приоритету естественного языка в поисковых запросах. Вместо упаковки ключевых слов и неестественных попыток вписать в статью все необходимые слова, Hummingbird отдал предпочтение естественному языку. Это масштабное изменение представляет собой новую траекторию и закладывает основу для будущих улучшений искусственного интеллекта и обработка естественного языка.

2015 Google Mobilegeddon

Это обновление значительно улучшило веб-сайты, оптимизированные для мобильных устройств. Таким образом, вместо неуклюжих интерфейсов, которые могли бы хорошо выглядеть на настольных компьютерах, улучшенная мобильная оптимизация создала гораздо лучший пользовательский интерфейс. Mobilegeddon и приоритизация мобильных сайтов помогли ускорить это изменение. Мобильный поиск вырос примерно с 20% в 2013 году до более чем 60% к 2021 году.

Mobilegeddon и приоритизация мобильных сайтов помогли ускорить это изменение. Мобильный поиск вырос примерно с 20% в 2013 году до более чем 60% к 2021 году.

2015 Google Rankbrain

Этот значительный алгоритм, который в некотором смысле является расширением Google Hummingbird, обеспечивает большую ясность для неструктурированных данных. Таким образом, его основная задача — понять, что вы ищете, даже если вы не используете «кавычки» вокруг своего запроса. Например, если вы наберете John Smith, он не будет искать всех Johns и всех Smiths и видеть, где они пересекаются; он ищет уникального «Джона Смита». Это также важный строительный блок в значении обработки естественного языка и его влиянии на поиск, а также локальный поиск.

2016 Google Possum

Запрашивает ли когда-нибудь Google ваше местоположение при поиске? Google Possum проложил путь к локальным результатам. Это обновление алгоритма внесло значительные изменения в локальное SEO и предложило местным предприятиям способ связи со своей аудиторией. Поэтому, если вы ищете «лучшие жареные цыплята», вы, вероятно, не увидите результатов универсального поиска по всем заведениям с курицей в мире. Вместо этого вы увидите индивидуальные пиццерии из вашего региона.

Поэтому, если вы ищете «лучшие жареные цыплята», вы, вероятно, не увидите результатов универсального поиска по всем заведениям с курицей в мире. Вместо этого вы увидите индивидуальные пиццерии из вашего региона.

2017 Google Fred

Если ваш веб-сайт полагался на тактику черного SEO, вы, вероятно, почувствовали падение после того, как Google внедрил Fred. Этот алгоритм также стремился наказать плохие веб-сайты переизбытком рекламы и меньшим количеством качественного контента.

2018 Google Medic

Любой, кто когда-либо задавал доктору Google ответы на различные медицинские вопросы, знает, как важно иметь надежные медицинские источники в результатах поиска. Этот алгоритм помог определить приоритет веб-сайтов с медицинским авторитетом, таких как клиника Кливленда или клиника Мэйо, по сравнению с другими сайтами без медицинского авторитета.

2019 Google BERT

Этот мощный алгоритм улучшил основу Hummingbird и определил приоритет поисковых целей и длинных ключевых слов. BERT улучшил качество поиска и расставил приоритеты релевантности.

BERT улучшил качество поиска и расставил приоритеты релевантности.

Как история SEO влияет на будущее SEO?

Узкоспециализированный процесс, часто требующий команды экспертов и сложных наборов данных и моделей, может сильно отличаться от более простого наполнения ключевыми словами и обмена ссылками предыдущих десятилетий. Но суть SEO-стратегии остается неизменной. Проще говоря, поисковые системы хотят дать читателям наилучшие возможные ответы на их поисковые запросы. Компании также хотят быть экспертами, которые дают тем, кто ищет наиболее желаемый результат, поэтому качество контента имеет значение. Поскольку машинное обучение и искусственный интеллект продолжают развиваться, мы увидим все более специализированные результаты поиска, которые используют обработку естественного языка для предоставления более качественных и релевантных результатов поиска.

Как я могу убедиться, что мой контент остается оптимизированным для SEO?

Google продолжает совершенствовать свои алгоритмы, обычно предлагая основные обновления алгоритмов два раза в год. С некоторыми рекомендациями довольно ясно, например, приоритизация статей в соответствии с E-A-T (экспертиза, авторитет и надежность). .

С некоторыми рекомендациями довольно ясно, например, приоритизация статей в соответствии с E-A-T (экспертиза, авторитет и надежность). .

Если вы заметили, что ваш контент теряет трафик без какой-либо логической причины, не паникуйте! Вероятно, это связано с новым обновлением ядра Google. Возможно, вам придется кое-что изменить, но если ваш контент хорошо написан, ваш веб-сайт технически исправен и вы отвечаете на вопросы, которые задают люди, ваш органический трафик должен вернуться или даже улучшиться во время следующего обновления. По этой причине вы должны держать долгосрочные результаты в перспективе. Иногда вы будете видеть быстрые победы, но годовая производительность часто является более точным показателем поиска, чем ежемесячные показатели.

Эти флуктуации алгоритма — одна из причин, по которой такие компании, как rellify , так важны. Их машинное обучение использует отраслевые данные, поэтому они оценивают только те данные, которые относятся к вашей компании и отрасли. Кроме того, их команда экспертов сочетает в себе лучшее из человеческого и машинного обучения, предлагая ценные отраслевые идеи. Таким образом, независимо от следующей главы SEO, вы можете быть уверены, что ваши усилия по контент-маркетингу принесут хорошие результаты. Обязательно обращайтесь, чтобы узнать больше.

Кроме того, их команда экспертов сочетает в себе лучшее из человеческого и машинного обучения, предлагая ценные отраслевые идеи. Таким образом, независимо от следующей главы SEO, вы можете быть уверены, что ваши усилия по контент-маркетингу принесут хорошие результаты. Обязательно обращайтесь, чтобы узнать больше.

Краткая история поиска и поисковой оптимизации

Проследить историю поисковой оптимизации — это то же самое, что попытаться проследить историю рукопожатия. Мы все знаем, что он существует, и мы знаем, что это важная часть бизнеса. Но мы не тратим много времени на размышления о его происхождении — нас больше всего интересует, как мы используем его изо дня в день.

Но, в отличие от рукопожатия, SEO довольно молод и часто меняется. Вполне уместно, что он относится к миллениалам — его рождение, по прогнозам, приходится на 19 лет.91.

И за свою относительно короткую жизнь он довольно быстро созрел и эволюционировал — вы только посмотрите, сколько изменений претерпел один только алгоритм Google.

Итак, с чего началось SEO и как оно стало таким чертовски важным? Присоединяйтесь к нам, когда мы отступим в прошлое и попытаемся разобраться в этом — как оказалось, это целая история.

Но сначала оглянемся на поисковые системы

Источник: Wayback Machine

Первая идея создания общего архива для всех мировых данных появилась в 1945. В июле того же года д-р Ванневар Буш — в то время директор ныне несуществующего Управления научных исследований и разработок — опубликовал в The Atlantic статью, в которой предлагал «сбор данных и наблюдений, извлечение параллельных материалов из существующая запись и окончательное включение нового материала в общую часть общей записи». Другими словами, мы считаем, что это сегодняшний Google.

Несколько десятилетий спустя, в 1990 году, студент Университета Макгилла Алан Эмтедж создал Archie, который, как говорят некоторые, был самой первой поисковой системой, хотя, согласно исследованию Билла Славски, президента и основателя SEO by the Sea, это остается предметом споров. . Тем не менее, Archie был тем, что Славски назвал «лучшим способом поиска информации с других серверов в Интернете в то время», и на самом деле это все еще (очень примитивная) операция.

. Тем не менее, Archie был тем, что Славски назвал «лучшим способом поиска информации с других серверов в Интернете в то время», и на самом деле это все еще (очень примитивная) операция.

Следующее десятилетие ознаменовалось несколькими поворотными событиями, когда сформировались более коммерческие версии поисковых систем, которые мы можем признать сегодня.

- Февраль 1993: Шесть студентов Стэнфорда создают Architext, который позже станет поисковой системой Excite. Некоторые, например Search Engine Land (SEL), говорят, что Excite «совершил революцию в методах каталогизации информации», облегчив поиск информации «путем сортировки результатов на основе ключевых слов, найденных в контенте, и внутренней оптимизации».

- Июнь 1993: Мэтью Грей дебютирует в World Wide Web Wanderer, который позже стал известен как Wandex.

- Октябрь 1993: Мартин Костер представляет ALIWEB, который позволяет владельцам сайтов размещать свои собственные страницы (к сожалению, многие владельцы сайтов не знают об этом).

- Декабрь 1993 : Существует по крайней мере три поисковых системы, «подпитываемых ботами» — JumpStation, паук RBSE и червь World Wide Web — что, вероятно, означает, что они работают на веб-роботах, которые сканируют как серверы, так и содержимое сайта для получения результатов.

- 1994: Поисковые системы Alta Vista, Infoseek, Lycos и Yahoo достигли своей цели.

- 1996: Соучредители Google Ларри Пейдж и Сергей Брин начинают создание поисковой системы, которую они первоначально назвали BackRub.

- Апрель 1997: Представлен AskJeeves, позже ставший Ask.com.

- Сентябрь 1997 г.: Google.com зарегистрирован как доменное имя.

Стоит отметить, что спустя почти двенадцать лет, в июне 2009 г., Microsoft выпустила Bing — его предыдущие выпуски также были известны как Live Search, Windows Live Search и MSN Search.

Но вот тут-то и вступает в игру само SEO.

Однако эти результаты нельзя было назвать качественными. И здесь, дорогие читатели, начинается история SEO.

Краткая история поиска и поисковой оптимизации

90-е годы

Источник: The Daily Dot . Проблема, как отмечалось выше, заключалась в качестве этой информации.

В то время как результаты поисковых систем соответствовали словам из пользовательских запросов, они обычно ограничивались только этим, поскольку подавляющее количество владельцев сайтов прибегали к набивке ключевыми словами — повторению ключевых слов в тексте снова и снова — для улучшения рейтинга (для чего не было никаких критериев), привлечь трафик на свои страницы и получить привлекательные цифры для потенциальных рекламодателей.

Был также небольшой сговор. Согласно SEL, в дополнение к наполнению ключевыми словами, люди использовали избыточные и «спамные обратные ссылки», чтобы повысить свой авторитет. Мало того, что в то время не было критериев ранжирования, но к тому времени, когда поисковые системы соответствующим образом исправили алгоритмы, уже существовали новые методы черной шляпы SEO, которые не были учтены исправлениями.

Но тут двое ребят из Стэнфорда придумали.

Источник: Stanford InfoLab

Когда Пейдж и Брин решили создать Google, это была одна из проблем, которую они хотели решить. В 1998 году они опубликовали в Стэнфорде статью под названием «Анатомия крупномасштабной гипертекстовой поисковой системы», где написали:

.…преобладающей бизнес-моделью коммерческих поисковых систем является реклама. Цели рекламной бизнес-модели не всегда соответствуют обеспечению качественного поиска для пользователей».

В той же статье Пейдж и Брин впервые упомянули PageRank — технологию, которую Google использует для ранжирования результатов поиска на основе качества, а не только ключевых слов.

Начало 2000-х

Источник: Wayback Machine

В начале 2000-х началось поглощение Google. В процессе превращения технологии поисковых систем в менее ориентированную на рекламу Google начал предоставлять рекомендации по белому SEO — тому типу, которого придерживаются «хорошие парни», — чтобы помочь веб-мастерам ранжироваться без какого-либо обычного подозрительного поведения из 90-х. .

2000-2002

Но, по словам Моза, рекомендации еще не оказали реального влияния на ранжирование, поэтому люди не стали им следовать. Отчасти это связано с тем, что PageRank основывался на количестве внешних ссылок на данную страницу — чем их больше, тем выше рейтинг. Но еще не существовало способа измерить подлинность этих ссылок — в начале 2000-х, как сообщается в блоге Marketing Technology Blog, все еще можно было использовать эти методы обратных ссылок для ранжирования страниц, которые даже не были связаны с критериями поиска. .

.

Но в 2001 году Брин и Пейдж появились в программе «Чарли Роуз», когда ведущий спросил их: «Почему это работает так хорошо?» В своем ответе Брин подчеркнул, что в то время Google был поисковой системой и никем иным, и смотрел на «сеть в целом, а не только на то, какие слова встречаются на каждой странице». Это задало тон некоторым первоначальным крупным обновлениям алгоритма, которые позволили более внимательно изучить эти слова. Посмотрите полное интервью:

Источник: Чарли Роуз

2003-2004

Этот подход к Интернету, основанному не только на словах, начал формироваться в ноябре 2003 года, когда в алгоритме Google появилось обновление «Флорида». Достаточное количество сайтов потеряли свой рейтинг для Search Engine Watch, чтобы назвать реакцию Флориды массовым «возмущением», но следует отметить, что многие сайты также выиграли от этого изменения. Это был первый крупный случай, когда сайты получали штрафы за такие вещи, как наполнение ключевыми словами, что свидетельствует о том, что Google делает упор на решение проблем в первую очередь для пользователя — в основном с помощью качественного контента.

В 2004 году существовала одна из самых примитивных версий голосового поиска Google, которую New York Times назвала незавершенным экспериментом. И хотя в то время технология была несколько инфантильной — просто посмотрите, как сначала выглядели инструкции — это также было сигналом к будущей важности мобильных устройств в SEO. (Оставайтесь с нами — подробнее об этом позже.)

Источник: Wayback Machine

2005: большой год для SEO0223

Одним из самых важных лет в мире поисковых систем был 2005 год. В январе этого года Google объединилась с Yahoo и MSN для создания атрибута Nofollow, который был создан отчасти для уменьшения количества спамных ссылок и комментариев на веб-сайтах, особенно в блогах. Затем, в июне, Google дебютировал с персонализированным поиском, который использовал чью-то историю поиска и просмотров, чтобы сделать результаты более релевантными.

В ноябре того же года был запущен Google Analytics, который до сих пор используется для измерения трафика и рентабельности инвестиций в кампании. Посмотрите его детское фото:

Посмотрите его детское фото:

Источник: Wayback Machine

2009: встряски SEO

В 2009 году в мире поисковых систем произошла небольшая встряска. Премьера Bing состоялась в июне того же года, когда Microsoft активно рекламировала его как поисковую систему, которая будет давать заметно лучшие результаты, чем Google. Но, как и предсказывала SEL, это не было «убийцей Google», и ее рекомендации по оптимизации контента не сильно отличались от рекомендаций Google. На самом деле, согласно Search Engine Journal, единственным заметным отличием была тенденция Bing отдавать приоритет ключевым словам в URL-адресах, а также отдавать предпочтение словам с заглавной буквы и «страницам с крупных сайтов».

В том же году, в августе, Google представила предварительную версию изменения алгоритма Caffeine, попросив общественность помочь протестировать «инфраструктуру следующего поколения», которая, по словам Моза, «предназначена для ускорения сканирования, расширения индекса и интеграции индексации и ранжирование почти в реальном времени».

Кофеин не был полностью представлен почти год спустя, когда он также улучшил скорость поисковой системы, но в декабре 2009 года был выпущен осязаемый поиск в реальном времени, с результатами поиска Google, включая такие вещи, как твиты и взлом. Новости. Это был шаг, который подтвердил, что SEO больше не только для веб-мастеров — с этого момента журналисты, веб-копирайтеры и даже менеджеры социальных сообществ должны будут оптимизировать контент для поисковых систем.

Here’s Matt Cutts, Google’s head of webspam, discussing Caffeine in August 2009:

Source: Wayback Machine // WebProNews

2010-Present

Source: Wayback Machine // Google

Когда вы вводите поисковый запрос в Google, довольно забавно видеть, что он предлагает. Это благодаря технологии Google Instant, запущенной в сентябре 2010 года. Сначала, по словам Моза, оптимизаторы «сгорали», пока они не поняли, что на самом деле это не дает никакого результата в ранжировании.

Но Google Instant, наряду с эволюцией SEO с 2010 года, был просто еще одним этапом миссии поисковой системы, которую нужно было решать за пользователя, несмотря на некоторые разногласия по поводу страниц, рейтинг которых фактически улучшился благодаря негативным онлайн-отзывам. По словам Google, в конечном итоге алгоритм был скорректирован, чтобы наказывать сайты, использующие такую тактику.

Подробнее о Google Instant, около 2010 г.:

В том же году значение контента социальных сетей в поисковой оптимизации также возросло. В декабре 2010 года и Google, и Bing добавили «социальные сигналы», которые сначала отображали любые письменные сообщения Facebook, например, из вашей собственной сети, соответствующие вашему запросу. Но он также начал присваивать PageRank профилям в Твиттере, на которые с некоторой частотой ссылались. На этом важность Twitter для SEO не заканчивается — следите за обновлениями.![]()

2011: год панды

Тенденция наказывать сайты за недобросовестное использование алгоритма Google будет продолжаться. Некоторые из этих инцидентов были более публичными, чем другие, в том числе случай с Overstock.com в 2011 году. В то время, согласно Wall Street Journal , домены, оканчивающиеся на .edu, обычно имели более высокий авторитет в глазах Google. Overstock использовал это в своих интересах, попросив образовательные учреждения разместить ссылку на его сайт и использовать такие ключевые слова, как «пылесосы» и «двухъярусные кровати», предлагая взамен скидки для студентов и преподавателей. Эти входящие ссылки улучшат рейтинг Overstock по запросам с такими ключевыми словами, пока Overstock не прекратил эту практику в 2011 году, а Google вскоре после этого не оштрафовал их.

Это был также год Panda, который впервые вышел в феврале того же года — обновление алгоритма, которое расправилось с фермами контента. Это были сайты с огромным количеством часто обновляемого низкокачественного контента, написанного с единственной целью — повысить результаты поисковых систем. У них также, как правило, высокое соотношение рекламы и контента, которое Panda научили вынюхивать.

У них также, как правило, высокое соотношение рекламы и контента, которое Panda научили вынюхивать.

Сама Panda претерпела несколько обновлений — так много, что Moz в своей хронологии изменений алгоритма Google отказался перечислить какие-либо из них, не являвшиеся основными после 2011 года. — для большинства из которых было трудно измерить влияние — до июля 2015 г.

2012: появился пингвин

В апреле 2012 года Google сделал, как он выразился, «еще один шаг к поощрению высококачественных сайтов», выпустив первое из многих обновлений Penguin. — предыдущий пост в блоге о меняющемся облике SEO. Пингвин ориентировался на сайты, которые более тонко использовали небелую тактику SEO; например, те, содержание которых может быть в основном информативным, но также усыпано спамерскими гиперссылками, которые не имеют ничего общего с h2 страницы, как в этом примере:

Источник: Google. рекламное пространство над «сгибом» или верхней половиной страницы.

В конце концов, Google перестанет нацеливаться на спам. Обновление алгоритма Payday Loan, на которое намекнули в июне 2013 года и которое было официально выпущено в мае следующего года, на самом деле было больше сосредоточено на запросах, которые с большей вероятностью приведут к спаму. Обычно это были поиски таких вещей, как, ну, ссуды до зарплаты и другие вещи, которые могли бы заставить вашу мать покраснеть. Google скорректировал свою систему ранжирования, чтобы предотвратить попадание спама в эти результаты, и, хотя это не обязательно повлияло на SEO-усилия законных сайтов, оно продемонстрировало усилия по сохранению подлинности результатов поиска.

Google становится локальным

Следуя традиции обновлений алгоритмов с именами животных, в 2014 году Google выпустил «Pigeon» (названный так SEL), который оказал значительное влияние на результаты локального поиска. В то время он, похоже, был разработан для улучшения запросов к Картам, которые начали обрабатываться с помощью некоторых из тех же технологий, которые применялись к другим его поисковым функциям, таким как «График знаний, исправление орфографии, синонимы». Локальные поиски должны были стать важным событием, и, как вы вскоре увидите, они будут только продолжаться.

Локальные поиски должны были стать важным событием, и, как вы вскоре увидите, они будут только продолжаться.

Затем, в 2015 году…

Самым большим SEO-объявлением после 2010 года могло быть обновление Google для мобильных устройств в апреле 2015 года, когда сайты, не оптимизированные для мобильных устройств, начали терять позиции. Это означало, что SEO больше не было связано с ключевыми словами и контентом — значение имел и адаптивный дизайн.

Компания Google объявила об этом изменении заранее, в феврале 2015 года, с помощью теста для мобильных устройств, который позволил веб-мастерам увидеть потенциальные проблемы и внести изменения до развертывания. Это было не последнее обновление Google для мобильных устройств — в августе 2016 года компания объявила о запрете мобильных всплывающих окон.

Что дальше?

В это трудно поверить, но похоже, что на горизонте нас ждут еще большие перемены.

Для мобильных устройств и не только

Поскольку использование мобильных устройств растет — 51% процентов цифровых медиа потребляются таким образом, по сравнению с 42% на настольных компьютерах — логично, что поисковая оптимизация будет продолжать склоняться в этом направлении.

Это уже очевидно, учитывая то, что Google предпочитает удобство для мобильных устройств. Мы прогнозируем, что будущая волна SEO будет в значительной степени относиться к голосовому поиску. Это имеет свою сложную историю и продолжает расти: 20% поисковых запросов Google в настоящее время выполняются голосом, как и 25% поисковых запросов Bing. И это усугубляется появлением таких цифровых персональных помощников с голосовым управлением, как Alexa от Amazon.

Хотя, возможно, не существует четкого способа оптимизации для голосового поиска , но — в основном из-за отсутствия аналитики в этой области — мы ожидаем, что эти ресурсы станут доступными, создав еще одну важнейшую опору SEO. .

Работа на местном уровне

Но это поднимает вопрос локализации в SEO и оптимизации результатов, чтобы они соответствовали региону. Это особенно верно в области голосового поиска — например, Yelp и другие бизнес-агрегаторы используются для ответа на голосовые запросы о том, что находится поблизости. Это возможность SEO для местных предприятий, поскольку их списки являются «всеобъемлющими, точными и оптимизированными для ссылок» на стороннем сайте.

Это возможность SEO для местных предприятий, поскольку их списки являются «всеобъемлющими, точными и оптимизированными для ссылок» на стороннем сайте.

Выход в социальные сети

В то время как введение Google в 2009 году поиска в реальном времени имело некоторые социальные последствия, социальные сети становятся все более важной частью стратегии SEO. Например, когда поисковая система начала индексировать твиты в 2011 году, это намекнуло на то, что в будущем пользователи будут искать информацию в социальных сетях так же, как и через поиск. На самом деле, это индексирование может быть версией Google для защиты от будущего — если вы можете себе это представить — на время, когда люди больше не будут использовать поисковые системы так, как мы это делаем сейчас.

Например, введите имя любой знаменитости, скажем, Чарли Роуза, чье видео мы поделились ранее. Первая страница результатов поиска по его имени включает его профили в Facebook и Twitter. Кроме того, обратите внимание на биографическую боковую панель справа — там также есть социальные значки со ссылками на его различные сети.

В то же время бренды пытаются найти и внедрить методы оптимизации, чтобы получить долю органического поискового трафика у конкурентов.

В то же время бренды пытаются найти и внедрить методы оптимизации, чтобы получить долю органического поискового трафика у конкурентов.